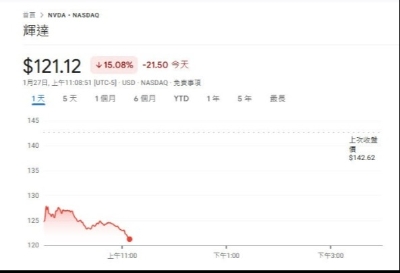

【來論】汪濤:DeepSeek衝擊及美國5000億AI投資計劃影響分析編者按:近日,中國人工智能(AI)大模型DeepSeek(深度探索)在全球引起強烈關注,快速登上各項APP排行榜前列。尤其是在AI發展最前沿的美國,DeepSeek的橫空出世,引發科技界、資本市場、政界的強烈震撼,甚至被美國部分人士稱為中美之間的“斯普特尼克時刻”(Sputnik moment,指蘇聯在美國之前搶先發射人類第一顆人造衛星,引起美國落後的恐慌)。而就在此前幾天,剛上任的特朗普宣佈了美國將以5000億美元投資人工智能產業發展的消息,亦引發各界關注。DeepSeek為何會引起如此大的衝擊,美國在AI方面的新舉措會產生何種影響,香港中通社、香港新聞網就此獨家約稿天使投資人、中興通訊前高級管理人員汪濤撰稿解讀。稿件全文如下: 一、DeepSeek衝擊波 近日,中國的DeepSeek在人工智能業內引發了巨大反響。為什麼DeepSeek會在業界引起這麼大的衝擊,並不是說DeepSeek R1的技術性能遠超過了OpenAI o1,而是在性能基本相同情況下,其訓練成本、訓練時間卻呈現數量級的下降,這兩者帶來的結果都是顛覆性的。原因在於: 訓練成本極低的主要因素是對算力需求數量級的下降,這樣一來英偉達人工智能算力卡市場需求就會受到極大的衝擊。 訓練時間從過去6個月下降到只有6天,這會使人工智能軟件的迭代速度發生質的變化。 人們可能非常疑惑,為什麼DeepSeek居然能在美國看起來如此領先的AI領域作出讓人炫目的成就?更重要的一個問題是:為什麼在看似美國領先的AI領域居然會存在如此巨大的改進空間?其實,這種巨大的改進潛力不僅不是什麼奇怪的事情,而且是整個美國引領的資訊技術領域存在的極為普遍的情況,只不過是DeepSeek把這層窗戶紙在全社會層面捅穿了而已。

二、提升資訊處理效率的最一般方法 1.去掉冗餘 要提升資訊處理效率,其最基本的原則其實是一樣的,就是盡可能減少“重複” —— 或者用資訊技術的語言叫減少“冗餘”。通過各種途徑去掉冗餘,就可提升資訊處理的效率。 如果是在存儲中,已經存了一份資訊,完全相同的資訊不用再重複地存儲,這就是存儲資訊的壓縮。一切文本、圖像、視頻的壓縮技術和內存的壓縮技術,都是通過各種途徑減少重複的資訊,這就可以節省存儲空間。 如果是已經計算過一遍的模型,就不要再重複地進行計算了,這就是演算法上運算量的壓縮。 2.適當降低精度 精度要求越高,一般來說對算力的需求就更大。尤其是一些關係不大的細節,簡單地去掉,就可以節省大量的算力以及存儲量。例如,圖像處理中,因為人對顏色的細節敏感度遠遠低於亮度,所以一般是在相鄰的四個像素的色度資訊中,只保留一個就可以了。這樣就可以直接將圖像資訊量減少一半。 在人工智能中,也在這種適當降低精度的方法,叫“量化”。所謂的“量化”是簡單地降低數據的精度,例如把4個位元組的浮點數據減少成2個位元組的浮點數據,存儲量就簡單地降低了一半。 3.適當簡化降低問題複雜度 如果要計算的參數越多,當然計算量就越大。如果對模型進行適當地簡化,減少參數和複雜度,計算量一般就會相應地下降。100億參數模型進行數據訓練,與1000億參數相比,簡單地來評估,在其他方面都一樣的情況下,計算量就會下降一個數量級。但複雜度或參數減少了,可能其性能表現等也會有所降低。如果能夠很好地選擇參數和調整好各項係數,有可能做到性能表現上差異會極小。這種方法在人工智能中叫“蒸餾”(Distillation)。 三、DeepSeek的特色技術 1. 三個重要的特色技術 要理解DeepSeek為什麼效率這麼高。需要認識到它的確有很多自己特色性的技術。從這些特色性的技術中可以看到,他們的出發點都是盡最大努力去減少人工智能中的各項成本。例如: l 不依賴於對要用於訓練的數據進行人工打標籤。 l 混合專家架構(Mixture of Experts:MoE)。 l 多頭潛在注意力(Multi-Head Latent Attention,MLA) 2. 打標籤是怎麼回事 要理解DeepSeek不依賴於人工打標籤,首先得理解打標籤是怎麼回事。人工智能軟件為什麼能理解人類的文本和圖像等數據?這個如果不理解對數據打標籤的話可能會感覺很神奇,但理解了這個後可能就沒有什麼神秘感了。如果從一開始就是把互聯網上的數據直接輸入人工智能軟件裏,要讓它準確理解是極為困難的。所以,原始的數據並不是直接輸給軟件,而是先由人去判斷並打上標籤。簡單來說,比如“美國”和“美圖”這兩個詞,前一個要理解成一個國家“美國”,後一個要理解成“美麗的圖片”簡稱。 這類理解是首先由人工智能的工程師制定好一些規則,然後交由專門進行打標籤的人去幹的活。所以,不要以為大模型的人工智能真的那麼神奇,真的有智能,其實還是人類智能的電腦化。但是,這麼幹的話有一個問題,就是人工打標籤是一個成本很高,效率也比較低,而且工作量很大的事情。減少打標籤的工作量,當然就會極大地降低訓練成本。 那DeepSeek為什麼可以不依賴於人工打標籤呢?最初的模型還是需要人工打標籤的,但是提升效率的方法就是去掉冗餘——已經打過標籤的應該就不用重複再打了。另外,採用強化學習的方法,事實上不是在事先對數據進行人工理解的判斷並打標籤,而是可以在模型運行之後作出人工的判斷來調整之前訓練的數據,也起到人工打標籤類似的作用。如果整體上是在之前已經採用人工打標籤的方法訓練過的基礎數據之上進行強化學習,就基本不需要再人工打標籤了。 3. 混合專家架構MoE 我個人事實上從瞭解通用人工智能技術的一開始就很推崇混合專家模型這個技術路線。那還是十多年前,連OpenAI都還沒有成立的時候,我就作為投資人在矽谷接觸到一些當時頂尖的通用人工智能創業公司。我當時就對“通用人工智能”這個概念非常有疑問。各種專業的人工智能技術早就有了,為什麼不通過整合不同專家系統來實現通用的人工智能呢?當時那些創業者的技術團隊給我的回復是:這種思路業界不是沒人提,但要提前進行數據的專業分類會非常麻煩,而且不同人的理解會不一樣。 人類也是分成各個領域專家的,要解通用的問題也是不同專家合在一起來實現。人工智能當然也會走向這個模式。 混合專家架構的好處是什麼呢?這個需要結合前面所說的強化學習。因為已經訓練出來的數據需要在新的與環境的交流中不斷地進化。純粹的通用人工智能,所有的數據與其他數據都可能有相關性,這個計算的量就太龐大了。但通過混合專家系統的專業分類,大多數數據的相關性計算可以只與自己專家模型內的數據進行,這就極大地降低了總體的計算量。 4.多頭潛在注意力MLA 簡單來說,當很多人去用人工智能軟件如DeepSeek或豆包等進行查詢的時候,輸入的查詢要變成電腦的語言,它叫鍵(Key)和相應的值(Value)。你馬上就可以想到,那麼多查詢肯定有大量的查詢是重複的。如果所有查詢全是獨立地在內存中存儲,當然會佔用大量寶貴的內存。那麼,如果把那些重複的查詢整合在一起,實現壓縮,那內存佔用是不是就非常小了?MLA其實就這麼簡單。實際進行查詢的時候解壓縮出來就和原來是一樣處理過程了。 四、為什麼美國的資訊技術會存在這麼大的改進空間? 美國引領了整個資訊技術的進程。這使得美國建立的資訊架構成了全世界的標準。其他國家的技術人員往往是不問為什麼標準會這麼建立的原因,直接拿過來就用。即使發現一些看似很不合理的地方,也會認為肯定會有什麼我們不知道的原因才會如此,人家美國肯定都想清楚了。事實上完全不是這樣的。 其實也可以說DeepSeek採用的技術沒有任何是真正原創,美國全都有。資訊技術實在是太多了,實現相同目標的技術路徑和方案可以有非常非常多。選擇不同的方案,可能會體現出不同的文化。 1. 各種資源的成本平衡問題 第一個問題是:軟件的實現涉及到很多方面資源成本的平衡: l 計算能力成本。 l 存儲能力成本。 l 網路帶寬成本。 l 編程的人工成本。 l 其他。 實際的產品實現中,需要根據不同資源的成本差異,設計不同的實現方案。 (1) 如果計算能力獲得很容易,存儲成本很高,那麼在演算法上就會傾向於算力依賴型,這樣更為經濟。 (2) 反之,如果存儲成本很低,計算成本很高,就可以傾向於採用算力極小化,歷史經驗知識依賴型演算法。 (3) 如果編程的人工成本和管理成本很高,計算和存儲能力的獲得都很容易且成本較低,就會傾向於用最簡單的編程演算法去實現,而不用太關注軟件產品計算和存儲的成本消耗和效率。這就是一種硬體依賴型的演算法。 (4) 如果硬體成本相對極高,就得通過更為複雜的編程去盡可能節省計算和存儲的硬體資源。 (5) 如果網路帶寬成本很高,就會追求需要傳輸的資訊更高壓縮。 所以,如果沒有以上各個方面成本的綜合平衡,是不能簡單地說哪種演算法或策略更好的。 但是,美國在引領資訊技術發展的過程中,也逐步地形成了他自己特定的文化。因為晶片的摩爾定律,計算和存儲能力是可以很容易獲得並迅速增長的,而美國的人工比較貴。所以,美國就形成不太關注計算和存儲效率的最優化,而主要關注編程的方便性、簡潔性、可讀性等。這個雖然不那麼絕對,但總體上是這樣。 2.商業因素 因為CPU是INTEL等公司生產的,他們嚴格按照摩爾定律不斷地成倍升級晶片性能。如果拋棄計算依賴型的演算法,過多地提升計算效率,新的CPU就不會那麼強烈的需求了。在整個資訊技術的硬體產品中,掌握CPU的公司無疑具有整人資訊技術架構最基本的標準控制能力。所以,在所有硬體中,掌握CPU的公司相比於存儲產品的公司,擁有更大的話語權。外設類的公司話語權就更弱了。 所謂的WINTEL聯盟,就是這兩家公司形成一種默契,微軟根本不用過於關注軟件的計算效率,這個問題交給INTEL來解決就可以了。微軟也樂得將更多精力關注於編程的簡單性和用戶介面的更加友好。因此,這種文化長期演變下來,就會在計算效率上形成巨大的改進空間。 這種計算效率非常低下的改進空間,在人工智能時代也延續到英偉達與OpenAI等形成的軟硬體體系上。英偉達自己的CUDA在為研發人員提供基於英偉達晶片很便利的開發平臺的同時,也遮罩了對最底層硬體的直接訪問和優化。 事實上,所有那些技術改進,提升計算效率的方法美國人都知道,甚至大多數都是他們最先提出來的。但因為這種文化的形成,他們不會去充分利用這些技術,僅此而已。 這就是為什麼DeepSeek可以將人工智能的計算效率提升這麼大的技術可能性所在。 五、美國5千億Stargate AI 投資計畫會產生什麼影響? Stargate AI是特朗普政府推動,由日本軟銀集團、美國開放人工智能研究中心和美國甲骨文公司三家企業將投資5000億美元,用於在美國建設支持人工智能(AI)發展的基礎設施計畫。這是一個非常類似中國基建投資的發展模式。從其計畫本身來說,對美國當然是非常好的。美國在以往只有羅斯福當政時期有過類似的通過基建大投資促進整體社會經濟發展的案例。但作為一種產業發展政策,美國不僅極少成功的案例,而且從很多自由派經濟學家來說,他們是一直極力反對政府這麼做的。所以,美國這種計畫能否真正落地是一個問題。 但我們假設其可以按計畫發展成功的話,我個人認為其影響是有非常積極一面的。這個計畫主要是建設用於AI的超級計算中心,基礎網路設施等。另外還有配套的教育、人才培養、創新孵化,AI應用層的金融與醫療的AI應用、製造業升級等。這個建設計畫本身就會帶動美國相關產業的市場銷售,建設了更好的AI基礎設施,類似中國的東數西算等工程,無疑會給美國未來的AI發展提供更好的基礎。 問題就在於,美國搞這種違反以前自由市場經濟理念的產業發展計畫缺乏經驗。關鍵就在於其能否真正落地。 (本文作者為天使投資人、中興通訊前高級管理人員汪濤,本網獲獨家授權刊發,轉載請註明出處) (本文為作者觀點,不代表本媒體立場) 【編輯:王少喆】

|